主机规划

根据上篇 CEPH 集群入门笔记-基础 制定规划

| 主机 | 集群内网IP | 角色 |

| 管理主机 | 192.168.52.1 | |

| CEPH01 | 192.168.52.11 | osd、mon、mgr |

| CEPH02 | 192.168.52.12 | osd、mon |

| CEPH03 | 192.168.52.13 | osd、mon |

3台CentOS8,2核心,1G内存,20G系统盘,20G OSD,精简置备,安装CEPH Nautilus。

跑在i7 8550u 16G 1T pm961上。

虚拟机双网卡,一个桥接到外网,一个连接到192.168.52.0/24的集群内网。

关于版本选择可以参考CEPH踩坑笔记

安装过程

准备工作

略过系统安装,安装时关闭了kdump节约内存,最小安装。

配置网卡到集群内网略过。

epel和remi源

[code]yum install -y epel-release[/code]

根据自己网络情况替换源

安装一大堆常用工具,ntp和ntpdate是用于同步时间,ceph对节点时间差要求高

[code]yum update -y && yum install -y bash-completion open-vm-tools vim htop nload lrzsz ntp ntpdate[/code]

修改/etc/hosts,方便集群之间访问

[code]cat <<EOF>> /etc/hosts

192.168.52.11 CEPH01

192.168.52.12 CEPH02

192.168.52.13 CEPH03

EOF[/code]

新建cephdeploy

[code]useradd -d /home/cephdeploy -m cephdeploy

passwd cephdeploy[/code]

授予sudo权限

[code]echo “cephdeploy ALL = (root) NOPASSWD:ALL” | sudo tee /etc/sudoers.d/cephdeploy

chmod 0440 /etc/sudoers.d/cephdeploy[/code]

对每个节点完成上述操作后回到主节点

登陆cephuser生成公钥并复制到其他节点

[code]ssh-keygen

ssh-copy-id cephdeploy@CEPH01

ssh-copy-id cephdeploy@CEPH02

ssh-copy-id cephdeploy@CEPH03[/code]

防火墙(待补充)

mon需要tcp 3300(v2)和6780(v1)

[code]sudo firewall-cmd –zone=public –add-service=ceph-mon –permanent

sudo firewall-cmd –zone=public –add-service=ceph –permanent

sudo firewall-cmd –reload[/code]

#mon需要6789端口

#osd需要6800:7300

#RGW需要7480

开始部署

回到root操作

添加ceph源,已替换成tuna镜像

[code]cat << EOF > /etc/yum.repos.d/ceph.repo

[ceph]

name=Ceph packages

baseurl=https://mirrors.tuna.tsinghua.edu.cn/ceph/rpm-nautilus/el7/noarch/

enabled=1

gpgcheck=1

type=rpm-md

gpgkey=https://mirrors.tuna.tsinghua.edu.cn/ceph/keys/release.asc

EOF[/code]

[code]yum install -y ceph-deploy python-setuptools[/code]

登陆cephdeploy用户

建立cephdeploy文件夹用于保存自动生成的配置文件

[code]mkdir ~/cephdeploy && cd ~/cephdeploy[/code]

创建集群

[code]ceph-deploy new CEPH01 CEPH02 CEPH03 #这一步会创建配置文件,这几个节点将会是mon

ceph-deploy install –repo-url https://mirrors.tuna.tsinghua.edu.cn/ceph/rpm-nautilus/el7/ –gpg-url https://mirrors.tuna.tsinghua.edu.cn/ceph/keys/release.asc CEPH01 CEPH02 CEPH03 #在每个节点上部署ceph软件包,可以自己替换源

ceph-deploy mon create-initial[/code] #初始化mon并收集集群密钥

添加MGR

[code]ceph-deploy mgr create CEPH01[/code]

添加OSD

[code]ceph-deploy osd create –data /dev/sdb CEPH01

ceph-deploy osd create –data /dev/sdb CEPH02

ceph-deploy osd create –data /dev/sdb CEPH03[/code]

结束部署

复制配置文件和管理密钥到节点,便于以后ceph命令的使用

[code]ceph-deploy admin CEPH01[/code]

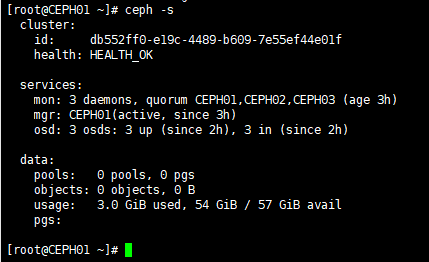

回到root执行ceph -s,可以看到集群状态